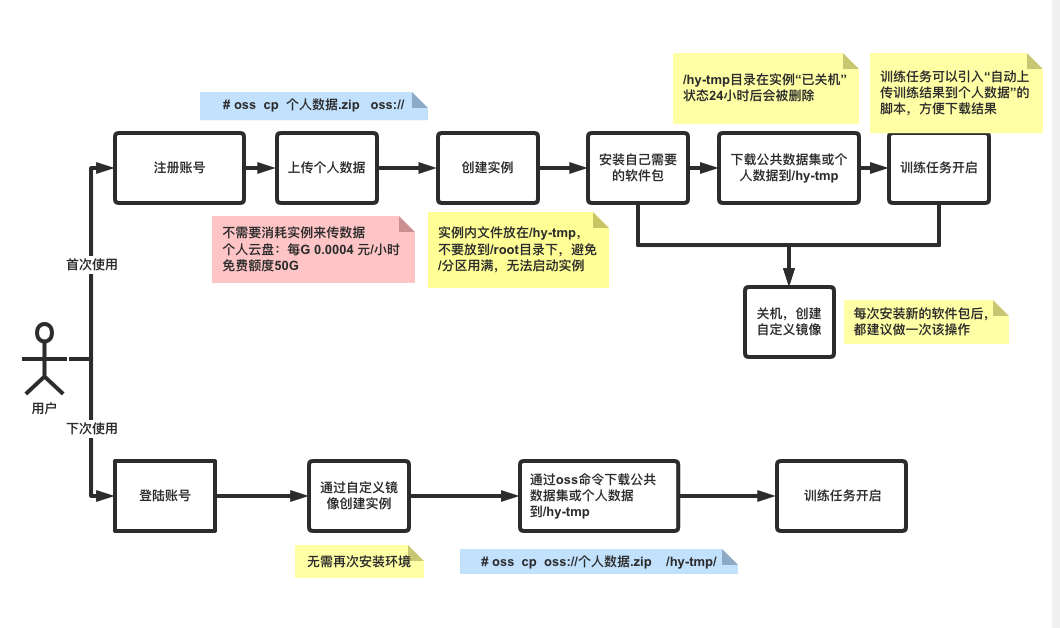

恒源云GPU平台使用指北

整体流程

使用OSS命令在上传或下载数据

将本地的zip压缩包通过压缩包上传至恒源云

#在windows中打开oss

# 查看命令帮助

help

# 登陆恒源云账号,使用恒源云的账号名与密码,账号名为手机号

# 如果是非中国大陆手机号码,需要加上带 + 的区号

login

Username:139********

Password:***********

139******** login successfully!

#在个人数据中创建文件夹

mkdir oss://datasets

#将本地电脑的 "个人数据.zip" 上传至平台个人数据中的 `datasets` 文件夹下

cp 个人数据.zip oss://datasets/

#查看我上传的 个人数据.zip

ls -s -d oss://datasets/

Listing objects .

Folder list:

oss://datasets/

Object list:

oss://datasets/个人数据.zip

Folder number is: 1

File number is: 1

在恒源云上下载上传的压缩包

oss help

# 登陆恒源云账号,使用恒源云的账号名与密码,账号名为手机号

# 如果是非中国大陆手机号码,需要加上带 + 的区号

oss login

Username:139********

Password:***********

139******** login successfully!

#查看个人数据中的datasets目录

oss ls -s -d oss://datasets/

Listing objects .

Folder list:

oss://datasets/

Object list:

oss://datasets/个人数据.zip

Folder number is: 1

File number is: 1

#下载个人数据到/hy-tmp/目录下

oss cp oss://datasets/个人数据.zip /hy-tmp/

#查看已下载到/hy-tmp/目录中的数据

ls /hy-tmp/

实例缺少libgthread-2.0.so.0库

解决方式:apt-get update -y && apt-get install libglib2.0-dev -y

解压压缩包

unzip xxxx.zip

更换源

#更换conda源

curl -#OL "https://download.gpushare.com/download/update_source"

chmod u+x ./update_source

./update_source conda

#更换pip源

curl -sOL "https://download.gpushare.com/download/update_source"

chmod u+x ./update_source

./update_source pip

保证后台运行

创建一个名称为 session1 的会话:

tmux new -s session1

进入会话后可以执行一些长时间运行的命令。当需要退出该会话,将会话放在后台运行时。可以执行 tmux detach 命令,或使用快捷键 Ctrl + B,再按 D 来退出会话。退出会话后底部会话信息会消失,并提示已从会话退出。

使用 tmux ls 命令可以查看当前所有的会话。

需要恢复会话时,使用 tmux a -t <session-name>,重新进入之前的会话中,如进入刚才名称为 session1 的会话:

tmux a -t session1

需要删除会话时。如果当前在会话当中,可以使用 Ctrl + D 或执行 logout 退出 SSH 登陆,即终止当前会话。在不在会话中时可以执行下列命令来删除会话。

# 删除指定会话

tmux kill-session -t session1

# 删除所有会话

tmux kill-server

执行训练并自动上传结果

在 /root 目录下使用 vim 创建一个 upload.sh 脚本。

cd

vim upload.sh

脚本内容如下,使用 vim 编辑器,输入 I 进入插入模式,粘贴下来整个脚本内容,再输入 Esc ,:wq 和 Enter 保存

#!/bin/bash

set -e

cd /hy-tmp

# 压缩包名称

file="result-$(date "+%Y%m%d-%H%M%S").zip"

# 把 result 目录做成 zip 压缩包

zip -q -r "${file}" result

# 通过 oss 上传到个人数据中的 backup 文件夹中

oss cp "${file}" oss://backup/

rm -f "${file}"

# 传输成功后关机

shutdown

关于shutdown关机警告

在一些官方老版本的镜像中,可能没有内置安装

shutdown命令来进行关机;在没有内置的镜像中执行shutdown指令则会返回System has not been booted with systemd as init system (PID 1). Can't operate.提示,从而无法完成关机。 建议在使用该脚本前,先手动执行shutdown命令来测试实例是否可以正常关机,如可以正常关机实例则可以正常使用该脚本;如果与上述返回一致,则使用如下指令来安装官方的shutdown指令,安装完成后再进行shutdown命令测试,测试无问题后再继续使用该脚本。

rm -f /sbin/shutdown

curl -L -o /usr/local/bin/shutdown "https://gpucloud-static-public-prod.obs.cn-east-3.myhuaweicloud.com/installation/shutdown"

chmod u+x /usr/local/bin/shutdown

source /etc/profile

给脚本添加执行权限。

chmod u+x upload.sh

在训练的任务代码中的最后调用此 /root/upload.sh 脚本运行即可,首次使用时建议先进行测试一下。如在 Python 代码中引用:

import os

os.system('/root/upload.sh')

对接公共网盘下载

登录实例后执行如下命令进行下载 gpushare-cli命令工具

curl -L https://download.gpushare.com/download/gpushare-cli-linux -o /usr/local/bin/gpushare-cli

chmod u+x /usr/local/bin/gpushare-cli

#执行gpushare-cli version命令验证是否安装成功

gpushare-cli version

v1.0.11

下载百度网盘数据到实例

通过gpushare-cli命令工具登录平台;所使用的账号密码为恒源云控制台的账号密码,通过-u参数指定账号,-p参数指定密码

~ gpushare-cli login -u 186xxxxxxxx -p xxxxxxxxxxxx

登录成功

百度云盘[*********]已授权<已选择>

阿里云盘[*********]已授权<已选择>

查看百度网盘的文件

#展开百度网盘中的所有文件,如下/dataset目录为是百度网盘中的文件目录

~ gpushare-cli baidu ls

加载中...

+------------------+------+--------+

| Path | ID | Size |

+------------------+------+--------+

| /dataset | | |

+------------------+------+--------+

#展开百度网盘中指定目录的所有文件

~ gpushare-cli baidu ls /dataset

# Path列中展示/dataset目录下的文件

# ID列中展示该文件对应的ID

# Size列中展示该文件的大小

加载中...

+---------------------------------------+--------------------+-----------+

| Path | ID | Size |

+---------------------------------------+--------------------+-----------+

| /dataset/data_scene_flow_calib.zip | 1061409882677800 | 1.631MB |

| /dataset/calib.zip | 438325381265667 | 1.631MB |

+---------------------------------------+--------------------+-----------+

下载百度网盘中的文件

#下载指令使用down,下载可以使用两种方式

#1. 指定网盘中的文件路径进行下载

#2. 指定网盘中的文件ID进行下载(如果文件名称有空格、特殊符号等字符,建议使用文件ID进行下载)

#指定网盘文件路径下载百度网盘中/dataset/目录下的calib.zip文件到当前实例的/hy-tmp/目录

~ gpushare-cli baidu down /dataset/calib.zip /hy-tmp/

检查网盘路径...

检查本地路径...

开始下载...

1.56 MiB / 1.56 MiB [===================================] 100.00% 1.90 MiB/s 0s

下载完成: /hy-tmp/calib.zip

#指定网盘文件ID下载百度网盘中/dataset/目录下的calib.zip文件到当前实例的/hy-tmp/目录

~ gpushare-cli baidu down 438325381265667 /hy-tmp/

检查网盘路径...

检查本地路径...

开始下载...

1.56 MiB / 1.56 MiB [=================================] 100.00% 380.45 KiB/s 4s

下载完成: /hy-tmp/calib.zip

查看下载到/hy-tmp/目录中的文件并解压

~ cd /hy-tmp/

~ ls

calib.zip

~ unzip calib.zip

上传结果到公共网盘(以百度网盘为例)

通过gpushare-cli命令工具登录平台;所使用的账号密码为恒源云控制台的账号密码,通过-u参数指定账号,-p参数指定密码

~ gpushare-cli login -u 186xxxxxxxx -p xxxxxxxxxxxx

登录成功

百度云盘[*********]已授权<已选择>

阿里云盘[*********]已授权<已选择>

上传实例中 /hy-tmp/dataset/train.zip文件到百度网盘中的 /Alaska/目录中(要确保百度网盘中存在Alaska目录)。

#上传指令使用up

#注意:上传数据实例中的文件必须要写绝对路径,也就是需要从 / 开始写路径,不能使用相对路径,例如 ./train.zip 或 ../train.zip。

~ gpushare-cli baidu up /hy-tmp/dataset/train.zip /Alaska/

计算文件大小...

上传中...

[==================================================] 100% 1/1

上传完成: train.zip

查看百度网盘中的文件验证是否上传成功

#展开百度网盘中的所有文件

~ gpushare-cli baidu ls

/dataset #/dataset目录为是百度网盘中的文件目录

#展开百度网盘中指定目录的所有文件来验证是否上传成功,也可以通过百度网盘客户端登录查看。

~ gpushare-cli baidu ls /Alaska

#返回如下三个文件为百度网盘中/Alaska/目录中的文件,其中train.zip为刚上传的文件

1061409882677800 -> data_scene_flow_calib.zip

864542844022467 -> calib.zip

827945728239665 -> train.zip

附:GPU算力表

| 型号 | 架构 | 显存 | FP16(half float) | FP32(float) | FP16 Tensor Core | FP32 Tensor Core |

|---|---|---|---|---|---|---|

| H800 | Hopper(第九代) | 80 GB | 204.90 TFLOPS | 51.22 | 1513 TFLOPS | 756 TFLOPS |

| H100 | Hopper(第九代) | 80 GB | 204.9 TFLOPS | 51.22 TFLOPS | 756.00 TFLOPS | 378.00 TFLOPS |

| A800 | Ampere(第八代) | 80 GB | 77.97 TFLOPS | 19.49 TFLOPS | 311.84 TFLOPS | 155.92 |

| A100 | Hopper(第八代) | 80 GB | 77.97 TFLOPS | 19.49 TFLOPS | 311.84 TFLOPS | 155.92 TFLOPS |

| RTX 4090 Ti | Ada Lovelace | 24 GB | 93.24 TFLOPS | 93.24 TFLOPS | 186.00 TFLOPS | 93.00 TFLOPS |

| L40 | Ada Lovelace | 48 GB | 90.52 TFLOPS | 90.52 TFLOPS | 181.05 TFLOPS | 90.50 TFLOPS |

| RTX 4090 | Ada Lovelace | 24 GB | 82.58 TFLOPS | 82.58 TFLOPS | 165.00 TFLOPS | 82.00 TFLOPS |

| A40 | Ampere(第八代) | 48 GB | 37.42 TFLOPS | 37.42 TFLOPS | 165.00 TFLOPS | 74.80 TFLOPS |

| A30 | Ampere(第八代) | 24 GB | 10.32 TFLOPS | 10.32 TFLOPS | 165.00 TFLOPS | 82.00 TFLOPS |

| RTX 4090D | Ada Lovelace | 24 GB | 73.54 TFLOPS | 73.54 TFLOPS | 147.00 TFLOPS | 73.00 TFLOPS |

| RTX 4080 Ti | Ada Lovelace | 16 GB | 73.50 TFLOPS | 73.50 TFLOPS | 147.00 TFLOPS | 73.00 TFLOPS |

| V100 | Volta(第六代) | 32 GB | 28.26 TFLOPS | 14.13 TFLOPS | 125.00 TFLOPS | 62.00 TFLOPS |

| A10 | Ampere(第八代) | 24 GB | 31.24 TFLOPS | 31.24 TFLOPS | 125.00 TFLOPS | 62.50 TFLOPS |

| RTX 4080 | Ada Lovelace | 16 GB | 48.74 TFLOPS | 48.74 TFLOPS | 96.00 TFLOPS | 48.00 TFLOPS |

| RTX 4070 Ti | Ada Lovelace | 12 GB | 40.09 TFLOPS | 40.09 TFLOPS | 80.00 TFLOPS | 40.00 TFLOPS |

| RTX 3090 Ti | Ampere(第八代) | 24 GB | 40.00 TFLOPS | 40.00 TFLOPS | 80.00 TFLOPS | 40.00 TFLOPS |

| RTX 3090 | Ampere(第八代) | 24 GB | 35.58 TFLOPS | 35.58 TFLOPS | 71.00 TFLOPS | 35.50 TFLOPS |

| RTX 3080 Ti | Ampere(第八代) | 12 GB | 34.10 TFLOPS | 34.10 TFLOPS | 70.00 TFLOPS | 34.10 TFLOPS |

| T4 | Turing(第七代) | 16 GB | 65.13 TFLOPS | 8.14 TFLOPS | 65.00 TFLOPS | 32.50 TFLOPS |

| RTX 3080 | Ampere(第八代) | 12 GB | 30.64 TFLOPS | 30.64 TFLOPS | 59.50 TFLOPS | 30.00 TFLOPS |

| RTX 4070 | Ada Lovelace | 12 GB | 29.15 TFLOPS | 29.15 TFLOPS | 58.30 TFLOPS | 29.15 TFLOPS |

| RTX 2080 Ti | Turing(第七代) | 11 GB | 26.90 TFLOPS | 13.45 TFLOPS | 53.80 TFLOPS | 26.90 TFLOPS |

| RTX 4060 Ti | Ada Lovelace | 8 GB | 22.06 TFLOPS | 22.06 TFLOPS | 44.12 TFLOPS | 22.06 TFLOPS |

| RTX 3070 Ti | Ampere(第八代) | 8 GB | 21.75 TFLOPS | 21.75 TFLOPS | 42.50 TFLOPS | 21.75 TFLOPS |

| RTX 3070 | Ampere(第八代) | 8 GB | 20.31 TFLOPS | 20.31 TFLOPS | 40.62 TFLOPS | 20.31 TFLOPS |

| RTX 2080 | Turing(第七代) | 8 GB | 20.14 TFLOPS | 10.07 TFLOPS | 40.28 TFLOPS | 20.14 TFLOPS |

| RTX 3060 Ti | Ampere(第八代) | 8 GB | 16.20 TFLOPS | 16.20 TFLOPS | 32.40 TFLOPS | 16.20 TFLOPS |

| RTX 4060 | Ada Lovelace | 8 GB | 15.11 TFLOPS | 15.11 TFLOPS | 30.22 TFLOPS | 16.11 TFLOPS |

| RTX 3060 | Ampere(第八代) | 8 GB | 12.74 TFLOPS | 12.74 TFLOPS | 25.58 TFLOPS | 12.74 TFLOPS |

| TITAN V | Volta(第六代) | 12 GB | 29.80 TFLOPS | 14.90 TFLOPS | ||

| T40 | Turing(第七代) | 24 GB | 28.75 TFLOPS | 14.38 TFLOPS | ||

| RTX A6000 | Ampere(第八代) | 48 GB | 38.71 TFLOPS | 38.71 TFLOPS | ||

| RTX A4000 | Ampere(第八代) | 16 GB | 19.17 TFLOPS | 19.17 TFLOPS | ||

| TITAN Xp | Pascal(第五代) | 12 GB | 12.15 TFLOPS | 12.15 TFLOPS | 不支持 | 不支持 |

| TITAN X | Maxwell 2.0 | 12 GB | 6.60 TFLOPS | 6.69 TFLOPS | 不支持 | 不支持 |

| RTX 1080 Ti | Pascal(第五代) | 11 GB | 11.34 TFLOPS | 11.34 TFLOPS | 不支持 | 不支持 |

| P40 | Pascal(第五代) | 24 GB | 11.76 TFLOPS | 11.76 TFLOPS | 不支持 | 不支持 |

| P100 | Pascal(第五代) | 16 GB | 19.05 TFLOPS | 9.53 TFLOPS | 不支持 | 不支持 |

评论区